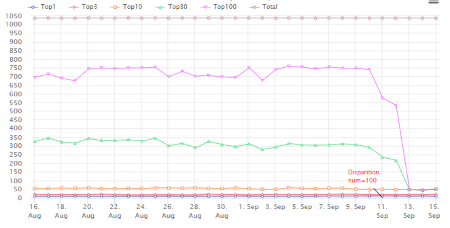

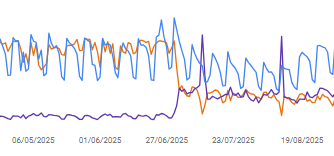

Nombreux sont les SEO et webmasters qui ont eu des sueurs froides ce 11 septembre 2025 en ouvrant leur outil de suivi de positionnement, et en constatant la perte de nombreuses positions au delà du Top 10. Effectivement les courbes de visibilité font peur :

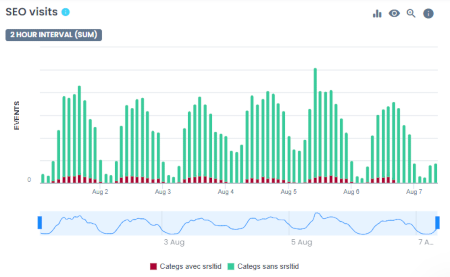

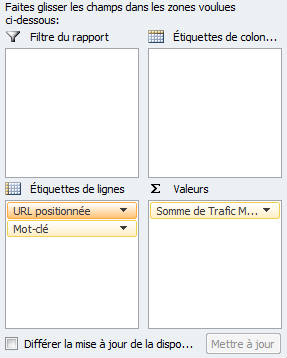

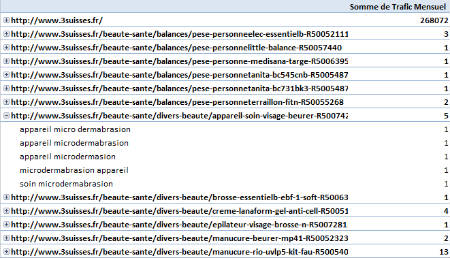

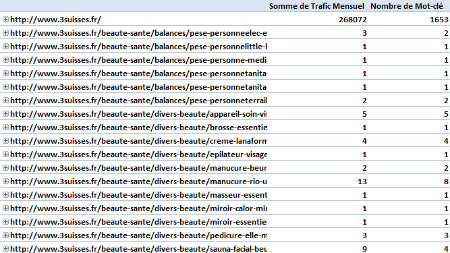

La cause en est l'abandon du paramètre "num=100" utilisé jusque ici par Google pour afficher 100 résultats au lieu des 10 par défaut. Ce paramètre étant exploité par de nombreux outils de ranking. Devenu inopérant, les outils vont désormais devoir s'adapter, avec de probables surcoûts à la clé. Cet abandon impacte aussi les données Google Search Console (GSC) : depuis le 11 septembre on observe une baisse sensible des impressions (surtout sur le desktop) et une hausse de la position moyenne. Les clics ne sont par contre pas affectés. La baisse des impressions pourrait signifier qu'un grand nombre d'impressions était généré par des outils utilisant le paramètre "num=100".

Google à ce stade n'a pas communiqué sur le sujet. Beaucoup d'observateurs pensent à une volonté de Google de limiter le scraping de ses pages de résultats par les IA, ainsi que par les outils SEO.

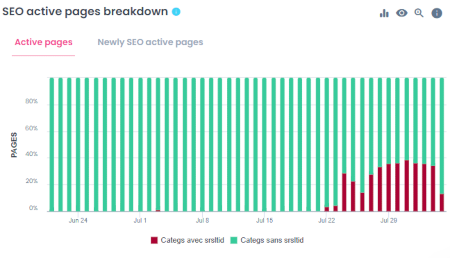

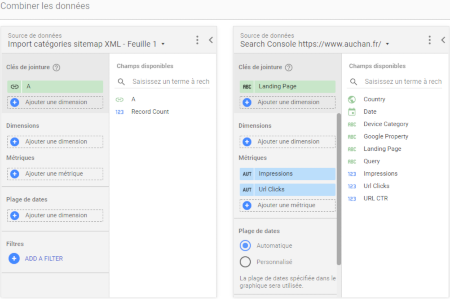

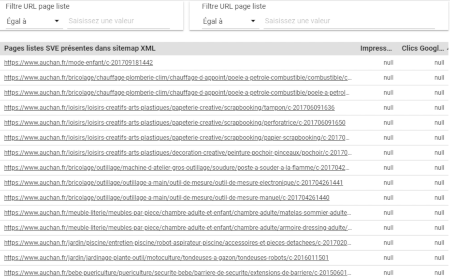

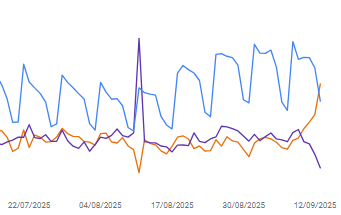

Cette action s'ajoute à un phénomène observé depuis début juillet dans GSC : une hausse brutale des impressions avait été observée à partir du 1er juillet 2025, associée à une baisse de la position moyenne quand un filtre était appliqué sur la France :

Ce changement en juillet pourrait être lié au fait que Google aurait alors changé sa méthode de comptage des impressions, en incluant des impressions qui auraient lieu si les AI Overviews (AIO) avaient été déployées en France. Cela ne reste cependant qu'une hypothèse